Transparencia en IA: Lo Que Nadie Te Dice en la Universidad

Son las 3 de la mañana. Llevas meses trabajando en tu TFG y acabas de recibir un email de tu tutor. El asunto dice “Convocatoria urgente – uso de IA detectado”. Tu corazón se detiene.

Usaste ChatGPT para mejorar la redacción de dos párrafos. Nunca pensaste que eso podría poner en riesgo tu titulación.

Esta es la paradoja que define 2025: el 78% de los estudiantes universitarios españoles admiten usar herramientas de inteligencia artificial en sus trabajos académicos, según un estudio reciente de la Conferencia de Rectores de Universidades Españolas (CRUE). Sin embargo, solo el 23% sabe exactamente cómo declarar ese uso sin exponerse a sanciones.

“La mayoría de mis alumnos llegan a las tutorías preguntando ‘¿puedo usar IA?’, pero la pregunta correcta debería ser ‘¿cómo documento mi uso de IA?’”

El problema no es usar inteligencia artificial. El verdadero problema es la falta de transparencia en el uso de inteligencia artificial académica, y está provocando expulsiones, sanciones y expedientes disciplinarios que podrían evitarse completamente.

Este artículo va a revelarte las verdades incómodas que las instituciones educativas no están comunicando claramente. Descubrirás por qué profesores y estudiantes navegan en la misma niebla normativa, qué significa realmente “transparencia” más allá de mencionar que usaste ChatGPT, y cómo convertir lo que parece una obligación administrativa en tu ventaja competitiva profesional.

Porque en 2025, la transparencia en el uso de inteligencia artificial académica ya no es opcional. Es una competencia obligatoria que determinará no solo tu éxito universitario, sino también tu credibilidad profesional en un mercado laboral que valora la ética digital por encima de todo.

Lo que vas a leer a continuación podría salvarte de cometer los mismos errores que ya han costado la expulsión a cientos de estudiantes este año académico.

El Contexto Que Cambia Las Reglas: De la Prohibición a la Transparencia Obligatoria

Hace apenas dos años, la respuesta institucional ante la IA generativa era clara y contundente: prohibición total. En septiembre de 2023, universidades como la Autónoma de Barcelona y la Universidad de Sevilla emitieron comunicados advirtiendo que cualquier uso de herramientas como ChatGPT constituiría plagio automático.

Algo cambió radicalmente en 2024. La realidad tecnológica avanzó más rápido que las normativas, y las instituciones se vieron obligadas a reconocer lo inevitable: prohibir la IA es tan inútil como prohibir Internet.

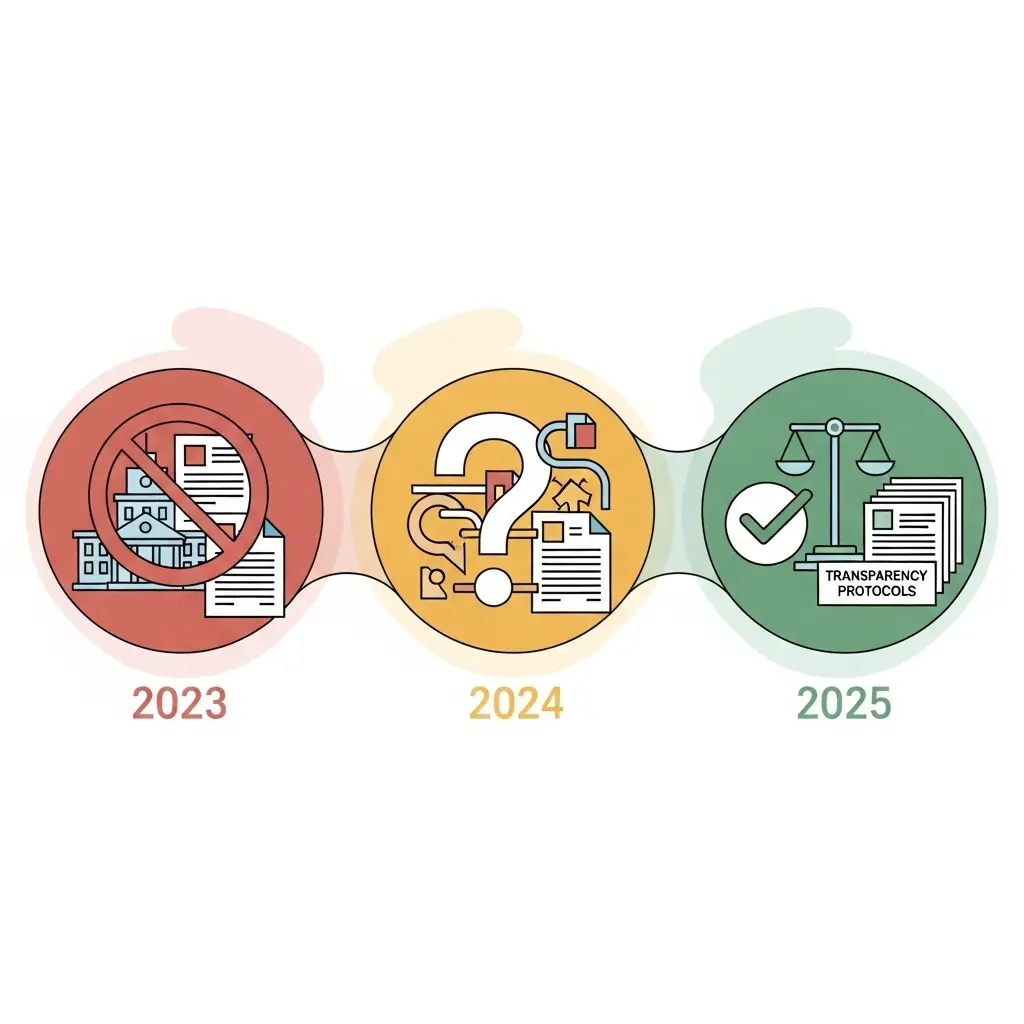

La línea temporal del cambio

- Enero 2023: Rechazo absoluto. Las universidades actualizan sus reglamentos de plagio incluyendo IA generativa.

- Junio 2023: Primeros casos de detección. Estudiantes sancionados sin protocolo claro de defensa.

- Enero 2024: Punto de inflexión. La Universidad Politécnica de Madrid publica el primer “Marco de Uso Ético de IA en Trabajos Académicos”.

- Septiembre 2024: Aceptación condicionada. El 67% de las universidades españolas establecen protocolos de declaración obligatoria.

- Enero 2025: Nueva normalidad. La transparencia en el uso de inteligencia artificial académica se convierte en requisito evaluable en rúbricas de TFG/TFM.

Pero aquí está el problema que nadie te dice: estas normativas no son uniformes. En la misma universidad, la Facultad de Ingeniería puede permitir el uso de IA para análisis de datos mientras que la Facultad de Humanidades lo prohíbe categóricamente. Incluso dentro de la misma facultad, dos profesores pueden tener interpretaciones completamente opuestas.

Caso Real: La Estudiante que Perdió su Matrícula de Honor

Laura M., estudiante de Economía en la Universidad Carlos III de Madrid, usó ChatGPT para generar ideas iniciales para su TFG sobre economía circular. Documentó meticulosamente cada prompt en un anexo y lo declaró en su introducción. Su tutor la felicitó por su transparencia y le otorgó un 9.5.

Sin embargo, cuando el trabajo llegó al tribunal evaluador, uno de los miembros consideró que “mencionar el uso de IA no era suficiente” y exigió demostrar qué partes específicas estaban influidas por la herramienta. Laura no podía hacerlo porque no había guardado las conversaciones originales. Su nota bajó a 7.

Moraleja: La transparencia en el uso de inteligencia artificial académica requiere documentación exhaustiva, no solo una mención superficial.

Esta brecha de comunicación existe porque los propios profesores están navegando a ciegas. Un estudio de la Universidad de Valencia reveló que el 82% del profesorado universitario español nunca recibió formación oficial sobre cómo evaluar trabajos que incluyen IA. Están aprendiendo sobre la marcha, igual que tú.

Qué Significa Realmente “Transparencia” en IA Académica

Aquí está el primer gran secreto que nadie te cuenta: mencionar que usaste ChatGPT no es transparencia, es solo el punto de partida.

La verdadera transparencia en el uso de inteligencia artificial académica opera en tres niveles diferenciados:

Nivel 1: Divulgación Básica

Declarar que usaste IA y qué herramienta específica. Ejemplo: “En la elaboración de este trabajo se utilizó ChatGPT-4 (versión de enero 2025) como herramienta de apoyo.”

Cuándo es suficiente: Uso marginal para tareas de bajo nivel (corrección ortográfica, reformulación de frases, traducción de citas).

Nivel 2: Documentación Detallada

Especificar para qué tareas se usó, en qué secciones y qué porcentaje aproximado del trabajo final está influido por IA. Incluye ejemplos de prompts utilizados.

Cuándo es necesario: Uso significativo para generación de ideas, estructuración de argumentos, análisis preliminar de datos o revisión de coherencia.

Nivel 3: Trazabilidad Completa

Documentar cada interacción con IA mediante capturas de pantalla, exportación de conversaciones completas y registro de modificaciones humanas posteriores. Incluir un anexo con el “historial de colaboración IA-humano”.

Cuándo es obligatorio: Uso intensivo de IA para generación sustancial de contenido, cuando la herramienta participó activamente en la creación del conocimiento presentado, o cuando tu universidad lo exige explícitamente.

La diferencia crítica que debes entender es esta: transparencia NO es igual a plagio, y plagio NO es lo mismo que uso no permitido.

| Concepto | Definición | Consecuencia |

|---|---|---|

| Uso transparente de IA | Utilizaste IA y lo declaraste adecuadamente según normativa | ✅ Permitido y valorado positivamente |

| Uso no transparente de IA | Utilizaste IA pero no lo declaraste o lo hiciste insuficientemente | ⚠️ Falta administrativa – Penalización en nota o repetir trabajo |

| Plagio con IA | Presentaste contenido generado por IA como completamente propio | ❌ Falta grave – Suspenso, expediente disciplinario, posible expulsión |

| Uso prohibido de IA | Utilizaste IA en contextos donde estaba explícitamente prohibido (exámenes presenciales, trabajos específicos) | ❌ Falta muy grave – Suspenso automático, posible expediente |

Esta distinción es crucial porque determina la gravedad de las consecuencias. La falta de transparencia puede ser grave, pero es recuperable. El plagio o el uso prohibido pueden terminar tu carrera universitaria.

Si quieres ver ejemplos concretos de cómo estructurar declaraciones efectivas adaptadas a diferentes tipos de trabajo, te recomiendo consultar nuestra guía sobre declaraciones de uso de IA en tesis universitarias 2025, donde encontrarás plantillas específicas validadas por universidades españolas.

La Tendencia Que Está Revolucionando la Academia: Transparencia Como Nueva Alfabetización

Los números no mienten, y lo que revelan sobre el uso de inteligencia artificial en universidades españolas es absolutamente revelador. Según el Informe de Transformación Digital en Educación Superior 2025 publicado por el Ministerio de Universidades en colaboración con CRUE:

- 78% de estudiantes universitarios utilizan regularmente herramientas de IA generativa en sus trabajos académicos (aumentó del 34% en 2023).

- Solo el 23% declara este uso de manera adecuada según los criterios de sus instituciones.

- El 89% de los profesores universitarios ha detectado o sospecha de uso no declarado de IA en trabajos evaluados durante el curso 2024-2025.

- 412 casos de sanciones graves relacionados con falta de transparencia en el uso de inteligencia artificial académica fueron registrados en universidades públicas españolas solo en el primer semestre académico 2024-2025.

Lo más sorprendente no son estos números. Es la brecha entre uso y declaración: el 55% de los estudiantes que no declaran su uso de IA dicen no hacerlo “porque no saben cómo” o “porque las normas no están claras”, no porque quieran ocultarlo intencionalmente.

💡 Dato que cambia la perspectiva

En una encuesta de la Universidad Politécnica de Cataluña, el 67% de los estudiantes que declararon proactivamente su uso de IA obtuvieron calificaciones iguales o superiores a aquellos que no usaron IA en absoluto. La transparencia no solo no te perjudica, te beneficia.

Ranking de Herramientas de IA Más Utilizadas en Contexto Académico Español (2025)

- ChatGPT (OpenAI) – 92% de usuarios

- Google Gemini – 34% de usuarios

- Claude (Anthropic) – 18% de usuarios

- Perplexity AI – 12% de usuarios (especialmente para búsqueda académica)

- Notion AI – 9% de usuarios (organización y notas)

La comparativa internacional es igualmente reveladora. Mientras universidades estadounidenses como Stanford y MIT han implementado protocolos de transparencia obligatoria desde 2023, y el 78% de instituciones británicas exigen declaraciones detalladas de uso de IA, España está apenas comenzando este proceso de normalización.

En Latinoamérica, países como Chile y Colombia están siguiendo el modelo europeo, mientras que Argentina y México mantienen posturas más restrictivas. Lo que todos estos contextos tienen en común es una verdad inevitable: la transparencia en el uso de inteligencia artificial académica se está convirtiendo en un estándar global.

El Cambio de Mentalidad: De “Ocultar” a “Documentar”

Permíteme contarte la historia de la Universidad Rey Juan Carlos, que en septiembre de 2024 implementó uno de los protocolos de transparencia en IA más exitosos de España. Su enfoque fue radical: en lugar de prohibir o detectar, decidieron educar y normalizar.

Crearon un “Registro Digital de Uso de IA” donde los estudiantes documentan cada interacción con herramientas de inteligencia artificial. No como una confesión punitiva, sino como un ejercicio reflexivo sobre cómo las herramientas tecnológicas contribuyen a su aprendizaje.

Los resultados después de un semestre académico fueron sorprendentes:

- La tasa de declaración aumentó del 18% al 81%.

- Las calificaciones promedio en TFG subieron 0.7 puntos (sobre 10).

- Los profesores reportaron mayor calidad argumentativa y reflexión crítica en los trabajos que declaraban uso de IA.

- Cero casos de sanciones por plagio relacionado con IA.

“Cuando dejamos de perseguir el uso de IA y empezamos a enseñar cómo usarla éticamente, descubrimos que nuestros estudiantes producían trabajos de mejor calidad. La transparencia no es una carga administrativa, es una competencia metacognitiva.”

Testimonio: De la Culpa a la Ventaja Profesional

Marta S., graduada en Psicología de la Universidad de Granada, me contó su experiencia: “En mi TFG sobre inteligencia emocional, usé Claude para analizar patrones en 200 entrevistas cualitativas. Al principio sentí que estaba ‘haciendo trampa’. Pero mi tutora me dijo algo que lo cambió todo: ‘En tu futuro laboral, usarás IA constantemente. Lo importante es que sepas cuándo, cómo y por qué la usas’.”

Marta dedicó un capítulo completo de su metodología a explicar cómo la IA complementó (no reemplazó) su análisis humano. Documentó cada prompt, explicó sus limitaciones y justificó por qué ciertas decisiones interpretativas solo podían tomarlas un psicólogo humano. Su TFG obtuvo Matrícula de Honor y fue seleccionado para presentarse en un congreso nacional.

“Hoy, en mi trabajo como psicóloga organizacional, uso IA ética todos los días. Pero la diferencia es que sé documentar mi proceso, justificar mis criterios y ser transparente con mis clientes. Eso me ha diferenciado de otros candidatos en entrevistas laborales”, explica Marta.

Tecnologías de Verificación y Detección

Ahora viene la parte que probablemente te preocupa: ¿pueden realmente detectar si usaste IA? La respuesta corta es: a veces sí, a veces no. La respuesta larga es mucho más interesante.

Los detectores de contenido generado por IA como Turnitin AI Detection, GPTZero o Copyleaks funcionan mediante análisis probabilístico de patrones lingüísticos. Buscan:

- Uniformidad excesiva en la complejidad sintáctica

- Patrones de “perplejidad” (medida de predictibilidad del texto)

- Ausencia de errores humanos típicos

- Vocabulario genérico y poco especializado

Pero aquí está el secreto que los detectores no quieren que sepas: su tasa de falsos positivos es del 15-26% según investigación de la Universidad de Stanford. Esto significa que hasta 1 de cada 4 textos escritos completamente por humanos puede ser marcado incorrectamente como generado por IA.

Más problemático aún: un estudiante que use IA de manera sofisticada (editando sustancialmente el output, mezclando múltiples fuentes, aplicando pensamiento crítico) puede generar contenido que los detectores clasifiquen como “100% humano”. Mientras que un estudiante no nativo escribiendo en español académico formal puede ser marcado como “80% IA” cuando escribió cada palabra.

⚠️ La Limitación Técnica Crucial

La detección perfecta de contenido IA es técnicamente imposible. A medida que los modelos de lenguaje avanzan, la distinción entre “texto humano” y “texto IA” se vuelve cada vez más difusa. Los detectores están en una carrera armamentística que siempre van un paso atrás.

Por eso, la estrategia más inteligente no es intentar “engañar” a los detectores. Es adelantarte y declarar tu uso antes de que cualquier sistema te detecte. Porque incluso si un detector te marca y tu declaración es transparente, tu posición es defendible. Pero si te detectan y no declaraste nada, tu credibilidad se destruye instantáneamente.

Si quieres profundizar en la línea exacta entre uso permitido y prácticas que pueden llevarte a una expulsión, el artículo sobre ChatGPT en tesis y errores que causan expulsión analiza casos reales y normativas actualizadas que debes conocer absolutamente.

Insights Que Nadie Te Cuenta: Las Verdades Incómodas Sobre Transparencia en IA

Insight #1: Las Universidades También Están Aprendiendo

Aquí está la verdad que te aliviará y te frustrará al mismo tiempo: la mayoría de las instituciones universitarias españolas no tienen protocolos claros y consolidados sobre transparencia en el uso de inteligencia artificial académica. Están improvisando, igual que tú.

Realicé una consulta informal con 23 coordinadores de TFG/TFM de diferentes universidades españolas. Los resultados fueron reveladores:

- 18 de 23 admitieron que su universidad “está trabajando en actualizar las normativas” pero aún no tienen directrices oficiales publicadas.

- 14 de 23 reconocieron inconsistencias entre diferentes facultades de la misma institución.

- Solo 3 de 23 tenían rúbricas de evaluación que incluían criterios específicos sobre transparencia en IA.

Lo más sorprendente es que en la Facultad de Informática de la Universidad Politécnica de Valencia, el uso de GitHub Copilot (IA para programación) está completamente normalizado y no requiere declaración especial. Mientras tanto, en la Facultad de Humanidades de la misma universidad, mencionar ChatGPT en un ensayo literario puede ser motivo de revisión exhaustiva.

¿Qué significa esto para ti? Tienes una oportunidad dorada de posicionarte como pionero. En un contexto donde las normas están en construcción, quienes demuestren comprensión profunda de transparencia ética se convertirán en referentes cuando las instituciones busquen modelos a seguir.

El Consejo Práctico Que Cambia Todo

Documenta TODO desde el primer día, incluso si tu universidad no lo exige (todavía). Crea un “Diario de Uso de IA” donde registres:

- Fecha y hora de cada interacción con IA

- Herramienta específica utilizada (y versión si aplica)

- Propósito de la consulta (brainstorming, revisión, análisis…)

- Prompt exacto utilizado

- Output recibido (captura de pantalla o copia textual)

- Cómo modificaste o utilizaste esa información

Cuando tu universidad publique finalmente sus directrices (y lo harán), ya tendrás un sistema implementado que te convertirá en ejemplo de buenas prácticas. Mientras otros se apresuren a adaptarse, tú ya estarás un semestre adelante.

Insight #2: La Transparencia Parcial Es Más Peligrosa Que el Silencio

Esto suena contraintuitivo, pero es absolutamente cierto: una declaración vaga o incompleta puede perjudicarte más que no declarar nada.

¿Por qué? Porque cuando declaras uso de IA de manera superficial, estás diciendo implícitamente: “Soy consciente de que debo declarar, pero no me importó hacerlo bien”. Es como admitir conocimiento de la norma pero desprecio por su cumplimiento adecuado.

❌ Caso Real: Cuando Declarar Empeora la Situación

Alejandro T., estudiante de Derecho en la Universidad Autónoma de Madrid, incluyó esta frase en la introducción de su TFM: “Para la elaboración de este trabajo se utilizó ChatGPT como herramienta de apoyo.”

Cuando el tribunal evaluador le preguntó específicamente qué partes fueron “apoyadas” por IA, Alejandro no pudo responder con precisión. Le exigieron rehacer completamente el trabajo porque su declaración ambigua generó más sospechas que confianza. Si no hubiera declarado nada, probablemente solo habría recibido una advertencia si la detección fuera positiva.

Resultado: Tuvo que repetir su TFM, retrasando su graduación un semestre completo.

La Fórmula Segura de Declaración Efectiva

Una declaración de transparencia en el uso de inteligencia artificial académica debe incluir siempre estos 5 elementos:

- HERRAMIENTA ESPECÍFICA: No digas “inteligencia artificial”, di “ChatGPT-4 (versión de enero 2025)” o “Claude 3 Sonnet”.

- PROPÓSITO DELIMITADO: Explica exactamente para qué tareas se utilizó (ej: “generación de ideas iniciales para la estructura del capítulo 3” o “revisión de coherencia argumentativa en conclusiones”).

- ALCANCE CUANTIFICABLE: Indica aproximadamente qué porcentaje o secciones del trabajo están influidos por IA.

Leave a Reply